Traditioneel vormen menselijke inspecteurs de laatste controle vóór uitlevering. Dankzij hun ervaring en scherpe blik weten zij waar ze moeten kijken en wat ze moeten voelen. Maar menselijke inspectie kent grenzen: het werk is repetitief, vermoeiend en soms zelfs onveilig. Naarmate productiesnelheid en volumes toenemen, kunnen zelfs ervaren operators defecten over het hoofd zien.

Daar komt automatisering en kunstmatige intelligentie (AI) in beeld. Het MAGICIAN-project, waarvan dit onderzoek deel uitmaakt, heeft als doel inspectie slimmer, veiliger en betrouwbaarder te maken. De achterliggende gedachte is eenvoudig: de veiligheid van medewerkers verbeteren én tegelijkertijd de productie-efficiëntie verhogen. De sleutel ligt mogelijk in het leren van machines om niet alleen te zien, maar ook te voelen.

Recente studies onderstrepen het belang van deze uitdaging. In 2023 betaalden autofabrikanten wereldwijd circa 51 miljard dollar aan garantieclaims, een aanzienlijke kostenpost (Mordor Intelligence, 2025). Een andere studie laat zien dat meer dan 27% van de kwaliteitskosten voortkomt uit defecten aan exterieurdelen (TRIGO Group, 2024). Zelfs kleine onvolkomenheden kunnen dus grote financiële gevolgen hebben.

Wanneer zien niet genoeg is: hoe AI een extra zintuig krijgt

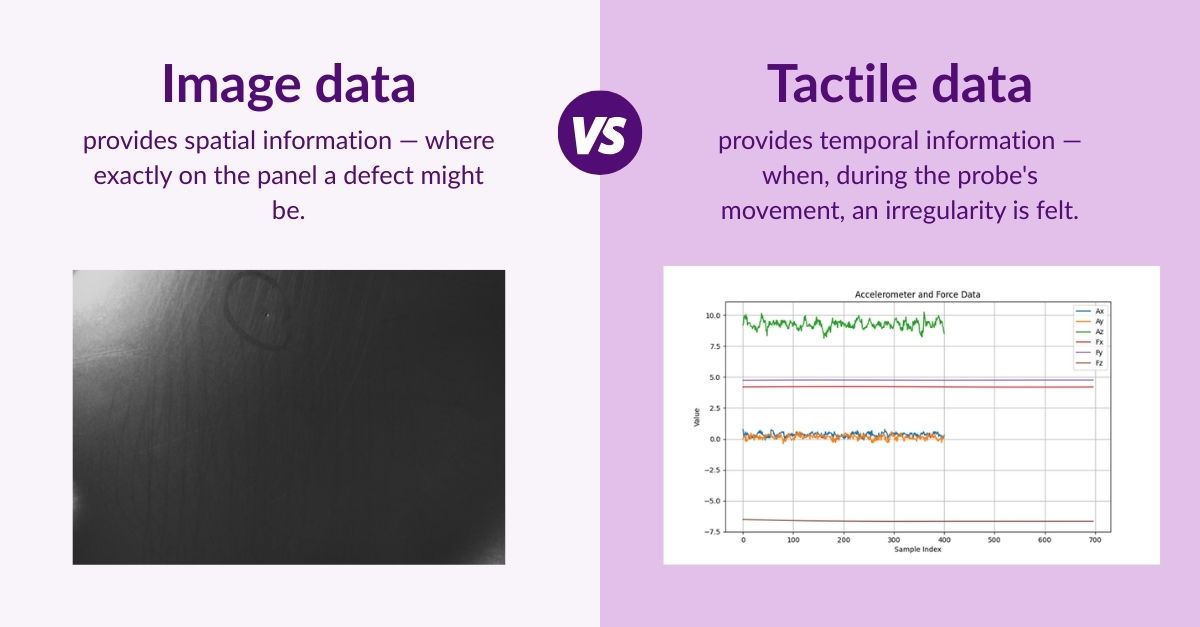

In het afgelopen decennium zijn camera’s en computer vision uitgegroeid tot krachtige instrumenten binnen kwaliteitsinspectie. AI-modellen kunnen worden getraind om krassen, deuken en lakdefecten met indrukwekkende nauwkeurigheid te herkennen. Maar visuele inspectie kent haar beperkingen. Sommige defecten zijn subtiel of blijven verborgen onder specifieke lichtomstandigheden. Andere zijn eenvoudiger vast te stellen via aanraking dan via zicht.

💡 Kijk naar hoe een menselijke inspecteur te werk gaat: die kijkt niet alleen naar een oppervlak, maar strijkt er ook met de vingers overheen. De ogen signaleren het zichtbare; de handen het subtiele.

Machines hebben tot nu toe vooral vertrouwd op visuele data. Het gevolg? AI kan defecten missen die zelfs een vermoeide menselijke vingertop nog zou voelen.

Machines leren voelen: tactiele data

Hier komen tactiele sensoren in beeld. Deze sensoren maken het mogelijk om oppervlakken via aanraking te analyseren. Door een tactiele sonde over een oppervlak te bewegen, kunnen minimale drukverschillen worden geregistreerd als een tijdreeks; een datastroom die inzicht geeft in hoe glad of ruw een oppervlak aanvoelt.

Stel je nu voor dat je deze tactiele informatie combineert met de beelden van een camera. Net zoals een menselijke inspecteur zowel ogen als handen gebruikt, kan een machine zo een vollediger en rijker beeld krijgen van het oppervlak. De uitdaging ligt, uiteraard, in het interpreteren van deze zeer verschillende datatypen en het effectief samenbrengen ervan.

Onze aanpak: visuele en tactiele data combineren

Het hoofddoel van dit onderzoek was om te verkennen hoe AI beelddata (visuele informatie) en tactiele data (informatie op basis van aanraking) kan combineren voor defectdetectie en lokalisatie op de plaatdelen van een auto.

De uitdaging is om deze twee datastromen zo op elkaar af te stemmen dat ze gezamenlijk kunnen worden geanalyseerd. In dit onderzoek is dat gedaan door beeldpatches (kleine uitsneden van het oppervlak van het plaatdeel) te koppelen aan tijdvensters (segmenten van tactiele metingen). Elk gekoppeld paar vormt één gecombineerd datapunt dat zowel visuele als tactiele informatie bevat.

Deze gecombineerde datapunten dienen vervolgens als input voor zogenoemde fusion networks: machine-learningmodellen die de kracht van beeld- en tactiele data combineren om te bepalen of er sprake is van een defect.

Ontwikkeling van fusienetwerken

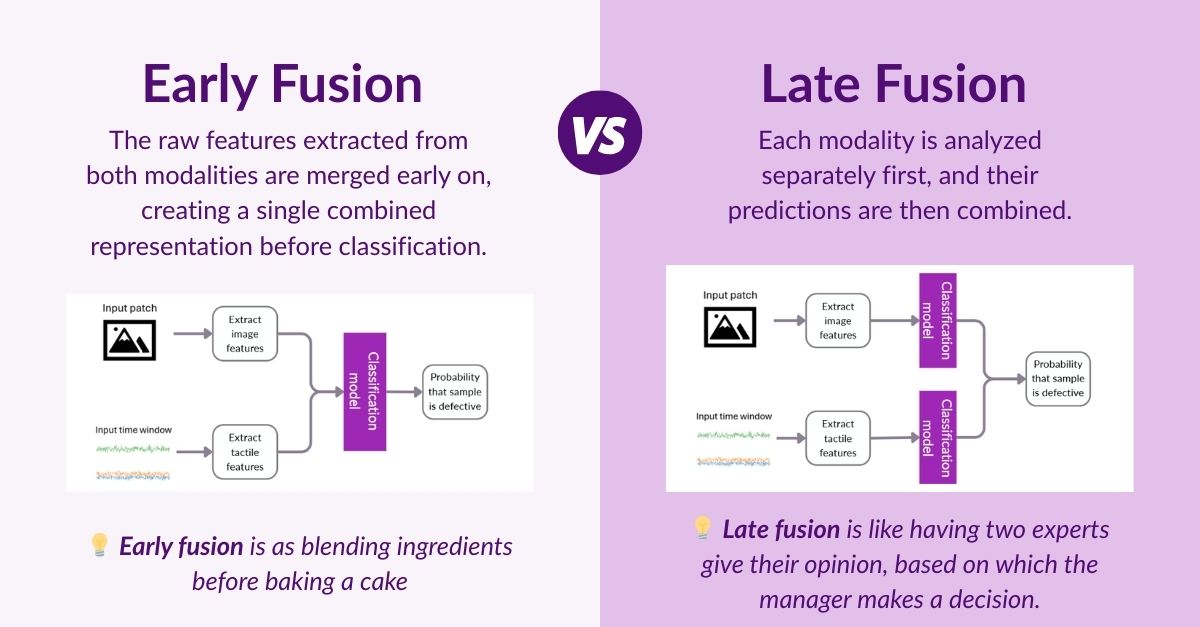

Er zijn verschillende manieren om twee informatiebronnen te combineren. In dit onderzoek hebben we systematisch twee hoofdstrategieën onderzocht: early fusion en late fusion.

Voor beide strategieën hebben we verschillende analysemethoden voor beeld- en tactiele data verkend. Daarbij keken we naar twee benaderingen: het handmatig selecteren van relevante signaalkenmerken op basis van expertkennis, en het inzetten van deep-learningmodellen die zelfstandig patronen in de data leren herkennen.

Testen onder realistische omstandigheden

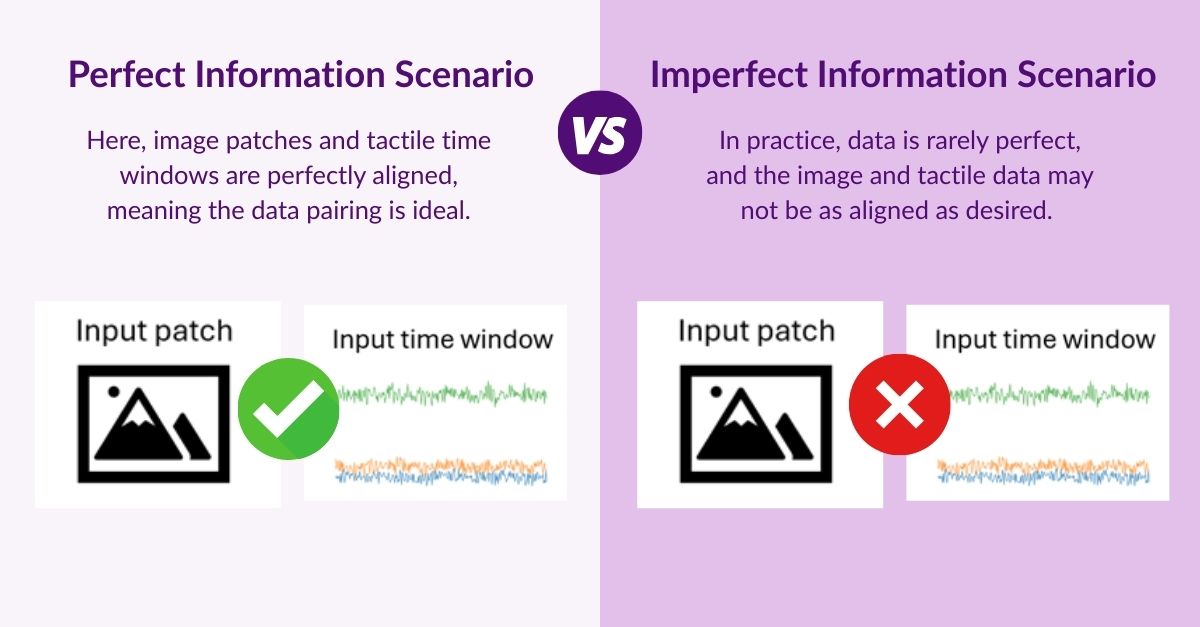

Een model is slechts zo goed als de omstandigheden waarin het wordt getest. Om de evaluatie eerlijk en representatief te maken, hebben we twee scenario’s onderzocht: een scenario met perfecte informatie en een scenario met onvolledige informatie.

In het scenario met onvolledige informatie hebben we bewust afwijkingen geïntroduceerd tussen de labels van beeldpatches en de labels van tactiele tijdvensters. Daarmee simuleren we fouten die in de praktijk kunnen optreden, bijvoorbeeld door een verkeerde synchronisatie tussen sensoren of een onjuiste labeltoewijzing. Zo konden we beoordelen hoe robuust de fusienetwerken blijven in een worstcasescenario.

De resultaten

In beide scenario’s presteerde het late fusion-model, waarin visuele en tactiele data worden gecombineerd, het best op het gebied van defectdetectie. Onder ideale omstandigheden behaalde het model een nauwkeurigheid van ongeveer 96%, tegenover 93% bij gebruik van alleen visuele data. Zelfs in het worstcasescenario (onvolledige informatie) bleef het gecombineerde model sterk presteren met 94%, en hield het een duidelijke voorsprong op systemen die uitsluitend op beelddata vertrouwen.

Deze percentages geven aan hoe nauwkeurig het systeem defecten kan detecteren. Hoe dichter de waarde bij de 100% ligt, hoe groter de kans dat vrijwel alle defecten correct worden geïdentificeerd, zonder onnodige foutmeldingen.

Zelfs deze, op het eerste gezicht, kleine verschillen kunnen in de praktijk grote gevolgen hebben. Als autofabrikanten jaarlijks ongeveer 51 miljard dollar uitgeven aan garantieclaims, en meer dan een kwart van de kwaliteitskosten voortkomt uit defecten aan oppervlakken en onderdelen, dan kan een verbetering van slechts enkele procentpunten in detectienauwkeurigheid al leiden tot honderden miljoenen dollars aan besparingen per jaar, door minder afgekeurde onderdelen, minder herstelwerk en een hogere klanttevredenheid.

Conclusie

Machines die zowel kunnen “zien” als “voelen” markeren een nieuwe fase in geautomatiseerde kwaliteitscontrole. Door tactiele en visuele data te combineren, kan multimodale AI defecten betrouwbaarder detecteren dan wanneer slechts één van beide benaderingen wordt gebruikt.

De resultaten laten zien dat multimodale defectdetectie niet slechts een technisch experiment is, maar een realistische en veelbelovende stap voor de maakindustrie. Binnen het MAGICIAN-project is een belangrijke stap gezet in het aantonen van dit concept. De volgende stappen – meer data, verdere verfijning en bredere toepassing – kunnen ervoor zorgen dat deze aanpak de stap maakt van het laboratorium naar de productievloer.

Over de auteur

Dit onderzoek is uitgevoerd door Stijn Craenen in het kader van zijn afstudeeronderzoek binnen het MAGICIAN-project bij Pipple.